Lo scorso 16 ottobre è stata finalmente dichiarata la general availability di Windows Server 2016, la nuova versione dell’ambiente server targato Microsoft, che non vedeva una nuova major release dall’ormai lontano 201 3. La distribuzione del nuovo sistema operativo era attesa da tempo, sia perché l’azienda di Redmond di solito propone un nuovo sistema operativo server circa un anno dopo aver lanciato la controparte dedicata al mondo dei computer desktop e laptop, sia perché il rilascio della versione definitiva è stata preceduta da una lunga sequenza di release preliminari (iniziata addirittura a due anni prima), che hanno offerto agli utenti interessati una lunga anteprima sulle novità in corso di sviluppo.

Il debutto di Windows Server 2016 non ha portato con sé grandi sorprese, ma le novità non mancano: innanzi tutto cambia il sistema di licenze, che non sono più basate sul numero di processori ma sono state rimodulate per essere proporzionali ai core disponibili sull’hardware di destinazione. Il costo di una licenza per 2 core (il pacchetto minimo acquistabile) è pari a un ottavo di una vecchia licenza per due processori: in media, quindi, i costi di licenza rimangono invariati.

Le edizioni principali disponibili sono tre: la più completa è denominata Datacenter, e offre tutte le funzioni avanzate dedicate in particolare alla gestione degli ambienti ad alta intensità di virtualizzazione.

Un gradino sotto si colloca la versione standard, che è pensata per gli ambienti non virtualizzati, oppure con un basso numero di sistemi virtuali (al massimo 2). Infine è disponibile anche l’edizione Essentials, che rappresenta l’entry level per questa famiglia, ed è limitata a un massimo di 25 utenti e SO dispositivi connessi. Per quest’ultimo prodotto il costo non è calcolato per core, ma ancora con la vecchia impostazione per processore.

A questa categorizzazione, di tipo principalmente commerciale (anche se, come vedremo, le tre edizioni hanno caratteristiche tecniche diverse tra loro), si somma la differenziazione nelle modalità di installazione: innanzi tutto, al contrario di quanto accadeva in passato, l’installazione completa di interfaccia grafica (Server with Desktop Experience) non è più proposta per default. Dev’essere selezionata esplicitamente durante il setup, altrimenti la procedura di installazione sceglierà la versione priva di interfaccia grafica nativa, chiamata Server Core. La versione

priva di interfaccia grafica aveva infatti dimostrato la sua perfetta efficienza anche per quanto concerne le operazioni di gestione e manutenzione, garantendo nello stesso tempo un’impronta più ridotta sull’hardware della macchina ospitante (fisica o virtuale) e una superficie di attacco più ridotta: quello che non c’è (l’interfaccia grafica) non può essere forzato.

Con la versione 2016, Microsoft ha compiuto un ulteriore passo in questa direzione, con l’introduzione della modalità di installazione Nano Server. Si tratta di una macchina amministrabile soltanto da remoto, ottimizzata per l’utilizzo in ambiente virtualizzato all’interno di datacenter e infrastrutture cloud o ibride.

Con la versione 2016, Microsoft ha compiuto un ulteriore passo in questa direzione, con l’introduzione della modalità di installazione Nano Server. Si tratta di una macchina amministrabile soltanto da remoto, ottimizzata per l’utilizzo in ambiente virtualizzato all’interno di datacenter e infrastrutture cloud o ibride.

I Nano Server sono ideali per essere usati come unità di calcolo, o appliance facilmente gestibili da remoto e spostabili tra host diversi (magari anche tra server locali e cloud} nel modo più semplice e veloce. Rispetto alle installazioni tradizionali, però, hanno alcune limitazioni significative: sono pensati per funzionare in modalità headless (letteralmente senza testa, cioè senza monitor, tastiera e mouse) e non offrono una vera e propria interfaccia di gestione locale. Propongono un semplice menu di manutenzione testuale e integrano una shell ridotta, ma sono pensati per essere gestiti da remoto. Hanno inoltre alcune limitazioni nei ruoli attivabili, e supportano

solo agenti, strumenti e applicazioni a 64 bit: l’ambiente stesso, quindi, è stato asciugato e razionalizzato per garantire un funzionamento quasi del tutto autonomo, con un’impronta molto ridotta sull’hardware ospitante

e la massima ottimizzazione. Il risultato è impressionante: un’immagine Nano Server è 25 volte più piccola rispetto

alla versione tradizionale di Windows Server 2016 (l’Os richiede tra 400 e 500 Mbyte sull’hard disk, in media)

LE NOVITÀ PRINCIPALI

Come abbiamo già accennato, Windows Server 2016 porta con sé molte novità interessanti, alcune di importanza

cruciale. Ma il loro impatto si sentirà maggiormente nei contesti più avanzati dal punto di vista tecnologico:

la versione Standard, infatti, non integra tutte le innovazioni, come per esempio le nuove funzioni dedicate alla gestione dello storage e del networking. Ma anche chi lavora in ambienti più semplici potrà trovare informazioni utili nelle prossime pagine: la seconda parte dell’articolo, infatti, è dedicata a una panoramica sull’installazione e i primi passi nell’ambiente Windows Server pensata proprio per chi non ha mai toccato con mano la nuova release del sistema operativo Microsoft, basata sull’edizione Essentials, la più semplice ed economica tra le versioni di Windows Server 2016

VIRTUALIZZAZIONE

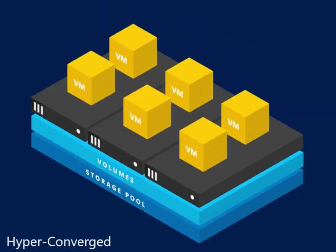

Com’era lecito attendersi, Microsoft ha dedicato grande attenzione alle funzioni e alle problematiche relative alla virtualizzazione: l’utilizzo di questa tecnologia è ormai penetrato in profondità nelle infrastrutture It delle aziende, portando grandi benefici in termini di scalabilità, razionalizzazione dei costi e capacità di rispondere a eventi inattesi. Inoltre, la virtualizzazione delle funzioni server è il primo passo per preparare l’infrastruttura It al passaggio, parziale o totale, dall’hardware locale al cloud, e rappresenta quindi un settore cruciale per Microsoft, che propone un ambiente cloud (Azure) tra i più potenti e integrati. La novità principale di Windows Server 2016 in questo ambito sono le macchine virtuali schermate (Shielded nella versione inglese): un insieme di tecnologie che garantisce l’indipendenza e l’isolamento dei sistemi guest rispetto all’host e agli altri nodi presenti nel fabric (letteralmente tessuto, ossia un ambiente virtualizzato massivo). Questo maggiore livello di isolamento è utile proprio nei contesti ad alta intensità di virtualizzazione, in cui il controllo puntuale su ciascun nodo dell’infrastruttura è difficile e dispendioso.

L’uso di macchine virtuali schermate protegge il loro contenuto e i flussi di lavoro implementati soprattutto nei confronti degli host e degli amministratori dell’ambiente virtualizzato, e garantisce una maggiore tranquillità per coloro che hanno ancora remore a spostare i flussi più delicati dai sistemi fisici a quelli virtuali.

Hyp er-V, l’ambiente di virtualizzazione di Microsoft, supporta anche i production checkpoint, immagini puntuali delle macchine virtuali che vengono create affidandosi alla tecnologia di backup implementata all’interno del sistema guest, invece che tramite la cattura di uno snapshot della macchina da parte dell’hypervisor.

Si segnalano anche funzioni avanzate di gestione della memoria, come per esempio il ridimensionamento a caldo della memoria assegnata alle virtual machine, durante il runtime, o la riallocazione dinamica della memoria che consente di sfruttare al massimo la Ram disponibile nei server, e moltissime novità nella gestione dei cluster.

La più significativa è probabilmente l’implementazione dei cosiddetti rolling update, per aggiornare i sistemi membri di un cluster in maniera progressiva, senza downtime. È stato migliorato anche l’accesso ai volumi condivisi da parte dei cluster, che possono sfruttare tecnologie di gestione dello storage avanzate, di cui parleremo più avanti.

Interessante è anche la funzione che permette l’accesso diretto ad alcune risorse hardware da parte di specifiche virtual machine: grazie a questa funzione si può, per esempio, riservare a un sistema guest una scheda video di livello workstation, per sfruttarne in modo completo le capacità computazionali grazie ai driver nativi, senza layer di intermediazione e condivisione.